Peux-tu te présenter en quelques mots ?

David BOYREL, je suis chez AVSimulation depuis 2005, anciennement OKTAL Paris. J’ai démarré par de la prestation puis j’ai rejoint l’équipe de développement où j’ai pu travailler sur SCANeR autour de nombreux sujets dans le domaine de la 3D : le moteur de rendu du visuel SCANeR, la réalité virtuelle et mixte, la simulation éclairage, la modélisation de capteurs, et les simulateurs de type Cave et casques de réalité virtuelle.

J’occupe désormais le poste de TechLead de l’équipe Terrain Visuel Sensors Unreal.

Qu’est-ce qu’un capteur ? A quoi sert-il sur un véhicule ?

Un capteur est un dispositif qui transforme une grandeur physique observée (une température par exemple) en une grandeur utilisable (typiquement une tension électrique). Les capteurs sont donc des dispositifs électroniques qui sont placés sur le véhicule.

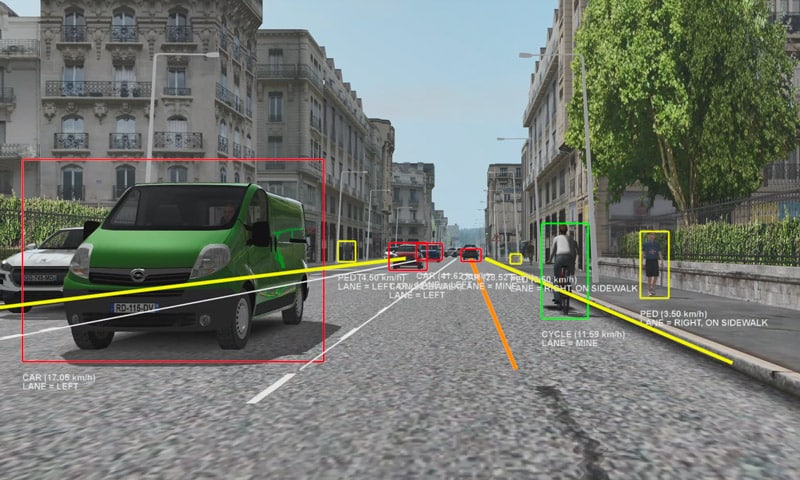

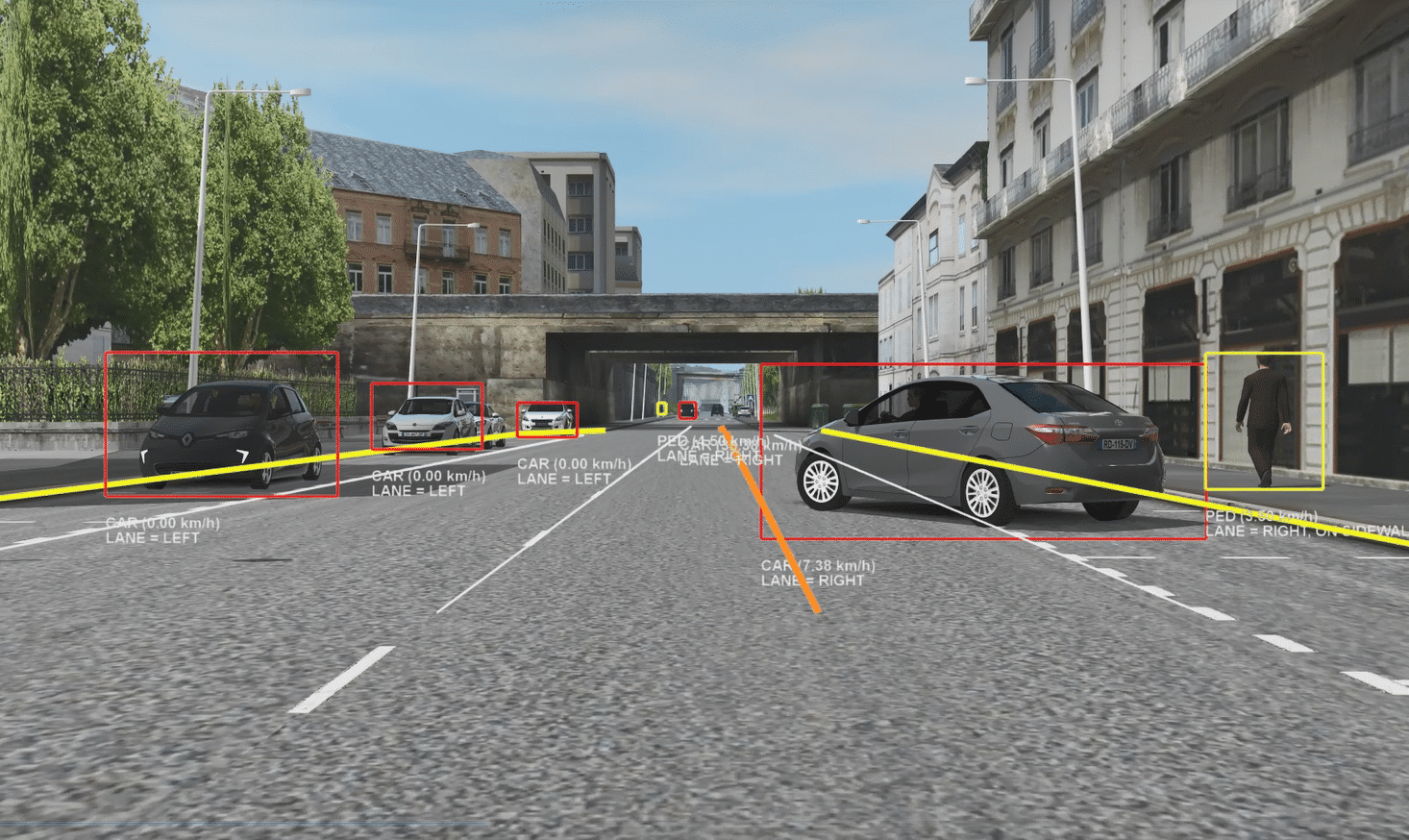

Leur rôle est de détecter et de comprendre ce qui les entoure en traitant le signal qu’ils perçoivent (une image, un signal radar) pour l’interpréter en tant qu’élément de l’environnement routier : repérer des panneaux ; savoir s’il y a d’autres véhicules environnants ; localiser les marquages au sol, etc. Autrement dit, ils ne retournent plus une simple valeur électrique mais une information. C’est le cas par exemple d’une caméra de recul qui est capable de « lire » les panneaux et d’informer le calculateur de la voiture qu’il faut régler la vitesse sur 80 km/h.

Sur les véhicules, les capteurs servent à concevoir des ADAS, systèmes d’assistance à la conduite. Ces derniers permettent de rendre les véhicules de plus en plus autonomes ou d’apporter des gains en termes de sécurité. Voici quelques exemples : la caméra de recul, la détection du changement de ligne, le détecteur de véhicule dans les angles morts, les systèmes d’arrêt d’urgence, la conduite assistée dans les embouteillages…

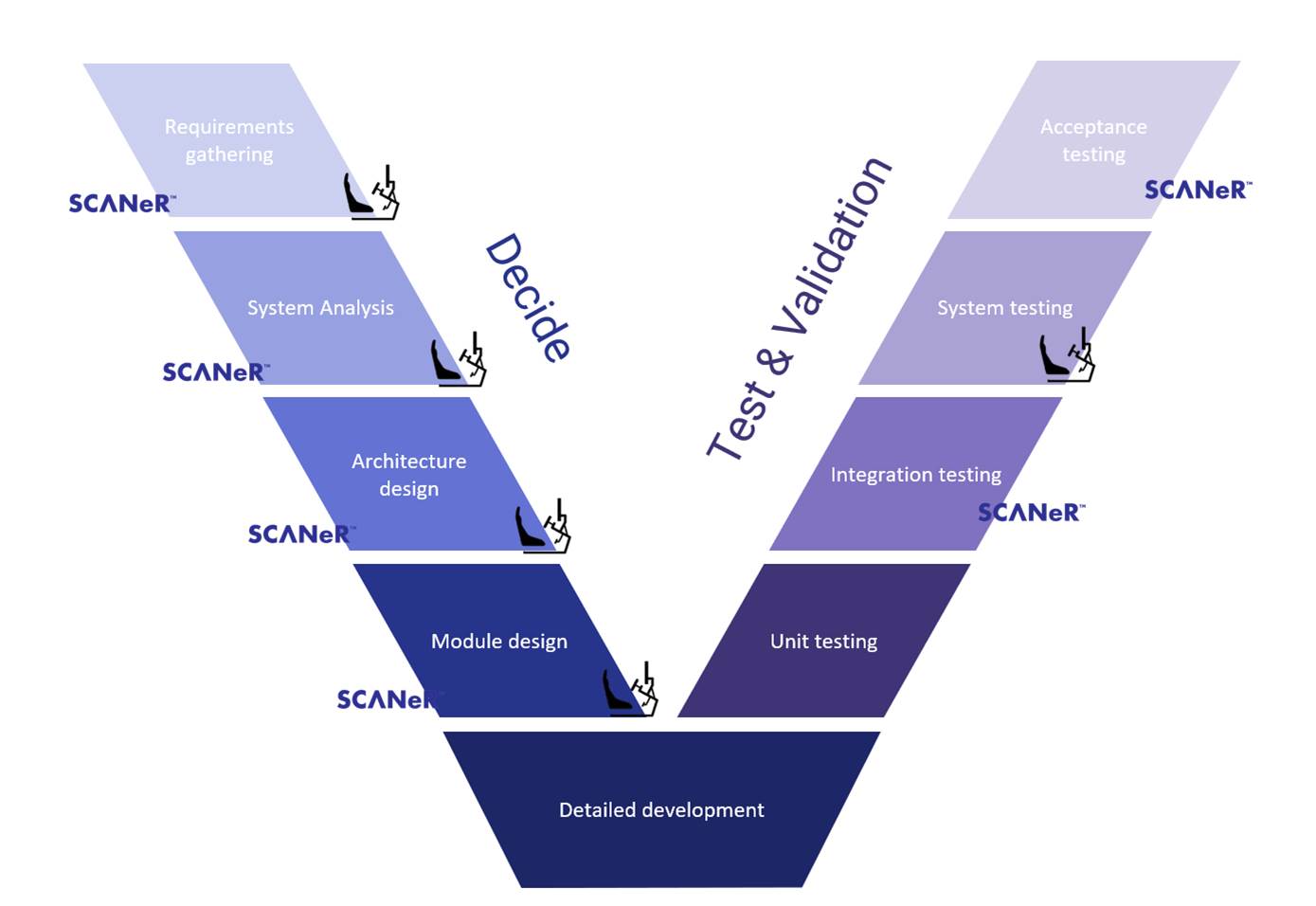

Aujourd’hui, le capteur permet d’analyser la scène qui se déroule autour de la voiture et ainsi de prendre des décisions face aux différentes situations. C’est un système qui permet de migrer vers la conduite autonome complète où les modèles de conduite autonome seront capables d’analyser des situations de plus en plus délicates, à partir de données capteurs de plus en plus riches. On assiste donc à une augmentation exponentielle de la complexité des ADAS et de leur mise au point. C’est pour cela que la simulation qui permet de prendre des décisions très tôt dans le cycle en V s’est imposée rapidement à tous comme une évidence.

Est-il possible de simuler les capteurs ?

Tout à fait et c’est d’ailleurs l’un des atouts majeurs de SCANeR.

La simulation permet de créer des situations spécifiques (traversée de piétons, freinage d’urgence, franchissement de ligne, etc.) et de générer les informations de détection qu’un ensemble de capteurs réels est capable de fournir dans ces situations. Ces informations sont envoyées à des modèles mathématiques de fusion de données, qui vont recouper et traiter les données fournies par tous les capteurs afin de reconstituer le plus fidèlement possible la situation dans laquelle le véhicule équipé se trouve.

A cette fin, la majorité des capteurs que nous fournissons dans SCANeR sont des capteurs dits « fonctionnels », ou que l’on appelle de niveau L1 : ils simulent les informations de détection, mais pas la technologie du capteur.

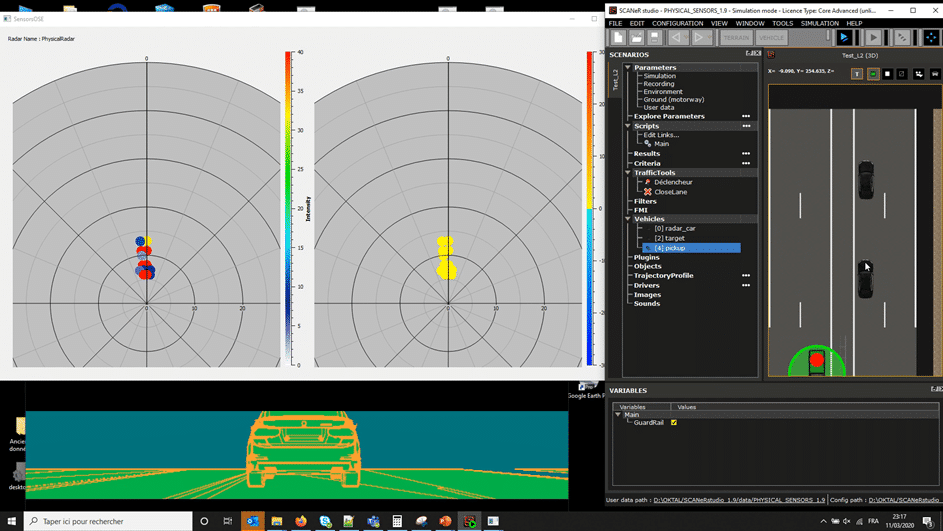

Des capteurs de niveau L3, qui tiennent compte de la technologie du capteur, sont aussi disponibles dans SCANeR.

A quoi servent les capteurs fonctionnels ? Sont-ils sans défauts ?

Les capteurs fonctionnels servent à mettre au point les modèles de conduite. Les ingénieurs qui les utilisent ne sont pas tant intéressés par le fonctionnement des capteurs eux-mêmes que par les informations qu’ils retournent et qui vont venir alimenter le système d’aide à la conduite qu’ils sont en train de mettre au point. Si je dois tester le fonctionnement d’un ADAS j’ai besoin que mon capteur m’indique qu’un piéton traverse. Je n’ai pas besoin de connaitre comment les lentilles focalisent la lumière sur le CCD de la caméra, ni la logique du programme de la caméra qui détecte le piéton en question.

En utilisant des capteurs fonctionnels et la simulation pour mettre au point les modèles de conduite, l’idée est de supprimer un maximum d’essais réels physique. Ces derniers sont coûteux et parfois dangereux.

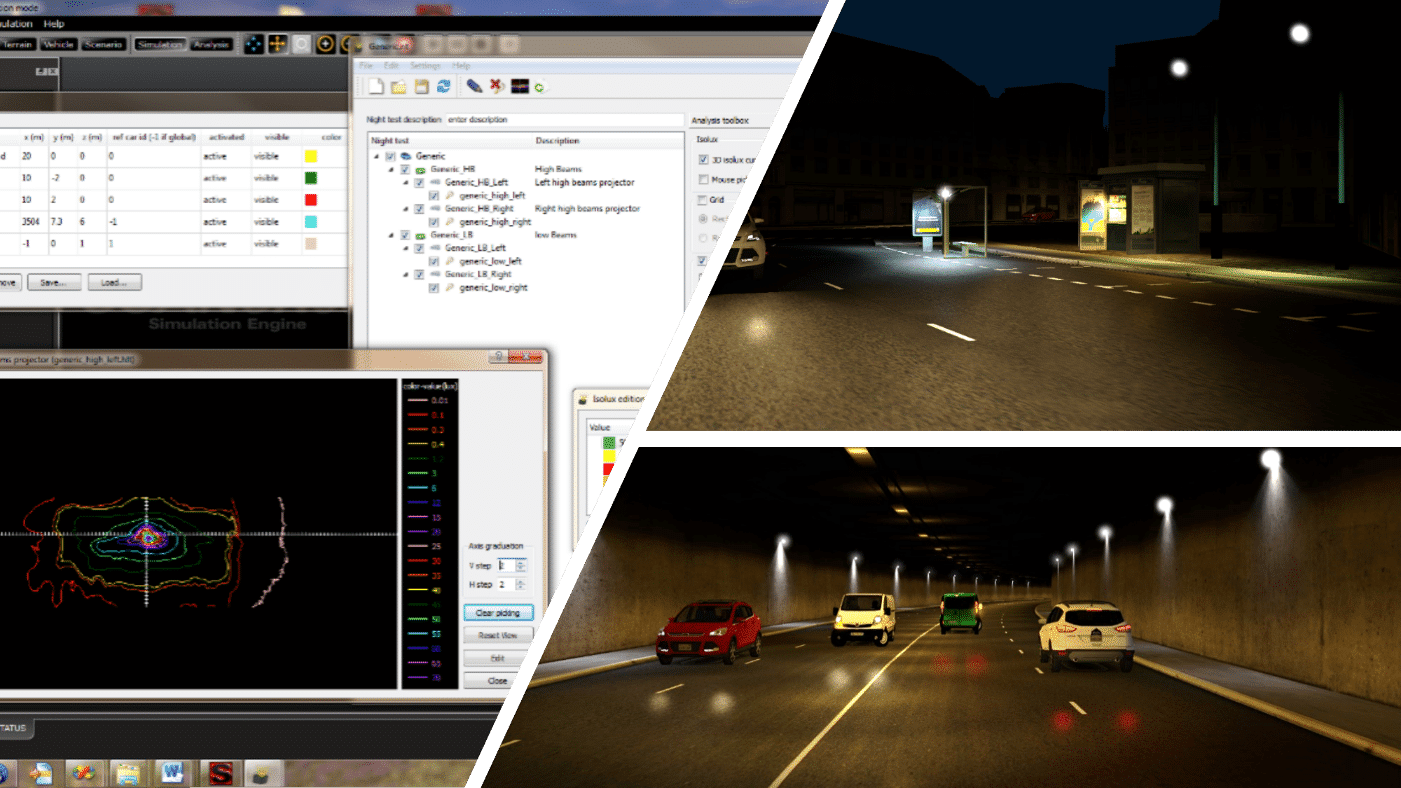

Un exemple peut aider à bien comprendre les enjeux. En plein été, à 15H00, il est tout à fait possible des simuler le brouillard Londonien qu’on rencontre à 6H00 en novembre. De même, alors que les projecteurs des véhicules sont de plus en plus considérés comme des ADAS, le retour sur investissement d’un simulateur Headlights se compte en mois. En effet, les projecteurs peuvent y être mis au point 24H/24 et 7 jours sur 7. Plus besoin d’envoyer des équipes au pôle pour bénéficier de nuits longues. Enfin, les ingénieurs travaillent alors en boucle très courte autour du simulateur ce qui signifie qu’il est facile et rapide d’intervenir sur le code et la logique de ce dernier. Si besoin est, il est facile d’inviter d’autres équipes à venir intervenir sur le ou les capteurs. Bien sûr tout ce que j’explique autour des projecteurs s’applique aux autres capteurs : radar, lidar, caméra…

De manière très pratique, l’orsqu’un constructeur automobile et des équipementiers conçoivent un capteur, ils vont s’en servir pour récupérer des informations du trafic environnant puis concevoir un modèle de conduite C’est cette dernière qui fera en sorte que dans telle situation le véhicule va ralentir, doubler, accélérer, etc.

Avec la simulation, il est possible de recréer toutes ces situations. En effet, SCANeR connait et « dessine » le monde autour du véhicule. Il sait qu’à 50 mètres un piéton traverse en dehors de clous. Il va donc simuler ce que le capteur est capable de détecter afin que le modèle qui analyse les informations puisse prendre une décision.

Si jamais la décision prise n’est pas bonne, les ingénieurs peuvent rapidement intervenir sur le code et relancer la simulation. A un stade plus avancé, il y aura sans doute des milliers de scénarios à exécuter. Dans ce cas, les simulations se déroulent la nuit en local ou dans le cloud et au matin, les ingénieurs peuvent se focaliser sur les scénarios où le modèle de conduite ne respecte pas les exigences : freinage trop tardif, accélération trop brusque…

Les capteurs fonctionnels de SCANeR sont en effet sans défauts car nous ne simulons pas leur technologie. Notre objectif est d’éviter d’introduire des erreurs dues à la simulation qui ne seraient pas présentes dans le capteur réel. Le fait que dans SCANeR nous puissions complétement paramétrer la simulation, permet au capteur de détecter exactement ce qu’il s’y passe. Nous n’introduisons pas d’erreurs via l’implémentation de l’algorithme de détection, qui renvoie exactement ce que fait la simulation.

Si l’utilisateur souhaite introduire des erreurs, il les fait en insérant des modèles d’erreurs statistiques qu’il aura préalablement paramétrer. Des perturbations sur des positions sont par exemple un type d’erreur fréquemment introduit dans SCANeR pour altérer la précision des points sur les différentes cibles détectées.

Quels types de capteurs sont disponibles dans SCANeR ?

|

Tout d’abord, nous avons les capteurs ultrason. L’alarme de recul qui se met à biper à l’approche d’un obstacle est un exemple. |

|

Les capteurs radar et caméra permettent de détecter des cibles qui se déplacent ou des panneaux. Par exemple, un radar va capter un panneau sans pouvoir lire ce qu’il contient. La caméra va le compléter en lisant ce qui est écrit sur ce dernier. |

|

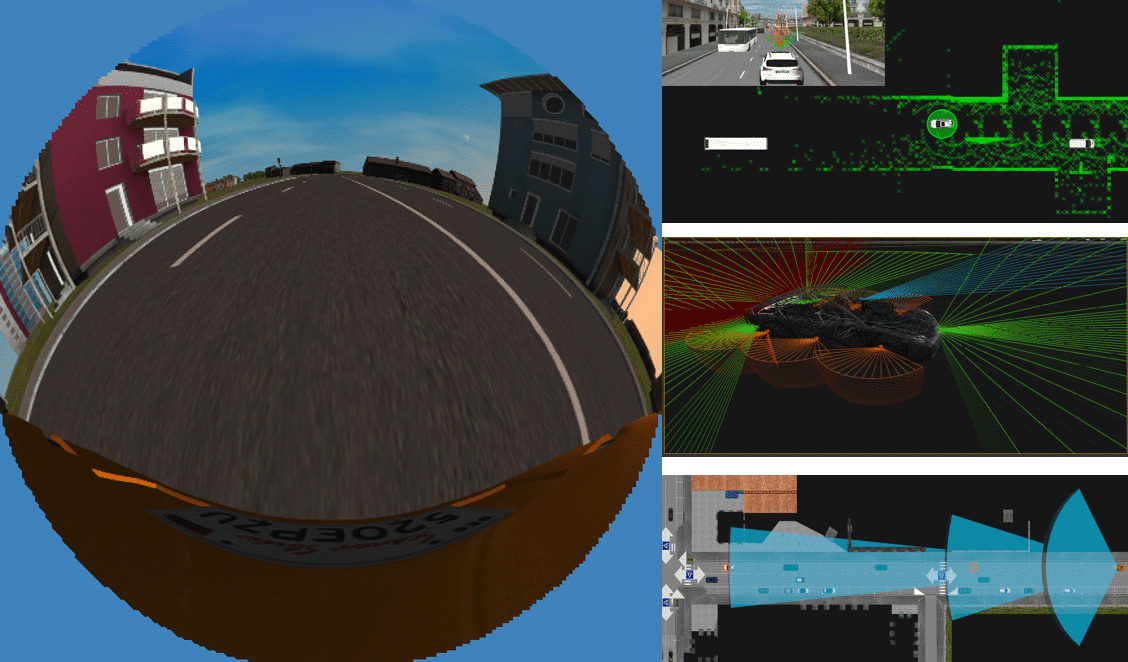

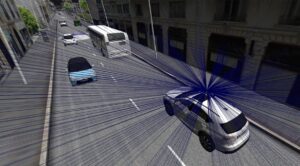

Ensuite, nous avons le capteur lidar, qui est l’acronyme de light detection and ranging. C’est un ensemble de lasers qui vont générer un nuage de point permettant de reconstituer une vue en trois dimensions de l’environnement entourant le véhicule équipé. |

|

AVSimulation propose aussi le capteur d’éclairage, ou luxmètre : il est capable d’évaluer la luminosité d’une scène. |

|

Enfin, le GPS, couplé avec l’Electronic Horizon, sont des capteurs qui détectent les trajectoires. |

Chaque capteur à ses spécificités et aucun capteur ne peut couvrir tous les usages. Le fait de simuler plusieurs capteurs différents ensemble permet de fusionner les informations retournées et de mettre au point des ADAS plus résiliant plus rapidement.

Combien de capteurs fonctionnels pouvez-vous simuler en même temps ?

No limit! Plus sérieusement l’architecture de SCANeR et très modulaire et distribuée par nature il est très facile de répartir la simulation des capteurs sur différents processeurs. Si le simulateur ou la plateforme de simulation dispose de plusieurs machines, l’ingénieur réparti la charge de calcul sur ces dernières. Plus il y aura de ressources matérielles à disposition, plus il sera possible de simuler des capteurs en parallèle. C’est aussi un état d’esprit. SCANeR n’oblige pas à investir lourdement dès le départ. Nous comprenons qu’au départ il s’agisse de mettre au point un arrêt d’urgence avec une station de travail et un capteur. Cela dit au fur et à mesure, l’ADAS va se sophistiquer. SCANeR accompagnera l’équipe en lui permettant d’ajouter des nœuds de calculs, des capteurs etc.

Qu’est-ce que les capteurs AVSimulation ont de plus pour nos clients ?

Le premier avantage de SCANeR est son architecture ouverte et ses nombreuses API (interfaces de programmation) qui donnent aux modèles de fusion un accès à toutes les données de la simulation.

Le second avantage est la facilité de coupler les capteurs avec les autres aspects de la simulation. Tout est ouvert, modulaire, accessible. C’est un argument déterminant pour les utilisateurs. Par exemple la simulation d’éclairage avec laquelle il est possible de simuler des matrices de LED, des systèmes permettant par exemple d’atténuer la lumière pour éviter l’éblouissement. Cela permet au conducteur d’éviter de passer manuellement des feux de route aux feux de croisement. Le capteur joue ici un rôle essentiel car c’est lui qui va détecter la cible (le véhicule que l’on croise), et permettre de baisser la lumière uniquement dans la zone de la cible pour ne pas l’aveugler.

Peux-tu confirmer que les capteurs utilisent le GPU (Graphics Processing Unit) s’il est présent ?

En effet, les capteurs les plus gourmands utilisent le GPU car ce dernier est indispensable pour faire un rendu 3D temps réel et évaluer les occlusions des éléments de la scène. A partir du moment où il y a une scène 3D, le GPU est utilisé. Depuis la version 2021.1, SCANeR bénéficie d’un nouveau moteur 3D (UXD) qui s’appuie sur les technologies et la plateforme Unreal. C’est une formidable opportunité et cela fait passer un cap à nos simulations de capteurs (gestions plus fines des matériaux, effet caméra, etc.). Il n’est pas interdit de penser non plus que la plateforme Unreal nous permette de développer des capteurs complémentaires comme des caméras avec des optiques spécifiques.

Quelle est la différence entre les capteurs de type L1, L2 et L3 ?

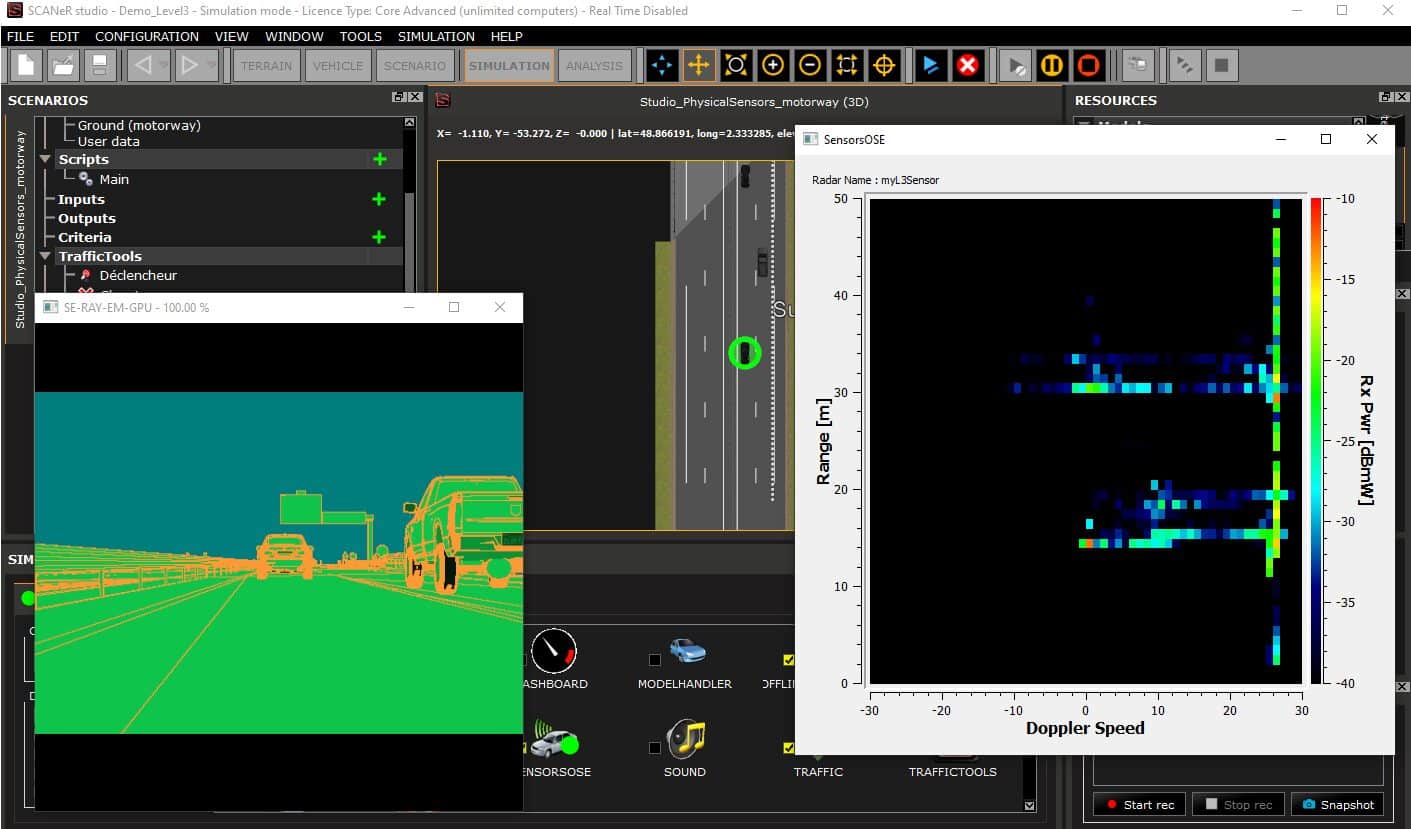

Les niveaux L1, L2 et L3 représentent le niveau de traitement du signal brut du capteur : un capteur de niveau L3 va fournir le signal brut, non traité : un signal Doppler pour un radar, une image pour une caméra. Un capteur de niveau L1 va fournir des données issues du traitement du signal brut, dans le but d’y déceler des véhicules, des panneaux, des lignes, issues de l’analyse du signal brut.

OKTAL-SE, qui fait également partie du groupe SOGECLAIR, simule la technologie des capteurs. Ils utilisent une description physique de la scène et les matériaux sont décrits en fonction de leur réaction face à certaines stimulations (onde radar, rayon lumineux). Dans SCANeR, la description de nos matériaux est purement visuelle. Or pour simuler un capteur radar, il nous faut une description différente dans le domaine électromagnétique, c’est donc OKTAL SE qui se charge de cette tâche.

Par exemple, pour le radar, on compte les 3 niveaux : L1, L2 et L3. Le niveau 1 est traduit par un capteur purement fonctionnel, où nous renvoyons comme sortie des informations traitées. Le niveau 2 est l’intermédiaire, c’est un signal brut déjà traité où l’on va avoir des spots d’intensité, autrement dit un regroupement de points avec un niveau d’intensité de réflexion du signal. Ce groupement va alerter l’utilisateur qu’il y a un obstacle, puis le traitement va permettre d’interpréter cette information et donc de savoir si c’est un panneau, un véhicule, un piéton ou autre. Le niveau 3 est le signal brut, comme par exemple le signal Doppler.

[ndlr : OKTAL-SE est un partenaire de longue date, leurs capteurs simulés sont intégrés dans SCANeR]

Dans le L2, il existe un radar et un lidar mais il n’y a pas de caméra ?

Il n’y a pas de niveau intermédiaire pour les caméras. La sortie brute d’une caméra est son image. Il n’existe pas de niveaux comme pour les radars et les lidars. D’un côté nous pouvons créer des capteurs caméra L1 qui envoient des informations de détection qui listent les entités de la scène. D’un autre côté, il est également possible de simuler la sortie image brute d’une caméra grâce au rendu 3D. Les utilisateurs de SCANeR peuvent récupérer l’image brute et l’analyser par eux-mêmes, pour ensuite faire leur propre détection.

Différents types d’effets peuvent être appliqués sur l’image. Souvent pour faire de la détection sur image, nous nous servons de la segmentation : des aplats de couleurs sont appliqués sur différents éléments de la scène pour apprendre à un algorithme d’analyse d’images, à détecter par exemple, un véhicule ou des lignes.

Un mot de conclusion ?

Nous migrons petit à petit l’ensemble du moteur 3D vers le nouveau moteur UXD. Un outil plus performant et très intéressant pour la simulation des Lidar entre autres, avec les millions de calculs indispensables qui doivent être faits en parallèle.

La plateforme Unreal* ouvre aussi beaucoup de perspectives, notamment sur la description des matériaux. Avec l’ancien moteur de rendu nous avions une description artistique des couleurs. Désormais, avec UXD nous apportons une description beaucoup plus physique et nous sommes capables de véritablement identifier les matériaux de la scène.

Enfin Unreal est un moteur de type PBR (Physic Based Rendering). L’implication immédiate pour tous les utilisateurs c’est que ces informations plus physiques apportent une richesse inégalée dans la détection et la simulation des capteurs.

*Pour en savoir plus sur la plateforme Unreal, découvrez l’interview : Tout ce que vous devez savoir sur l’utilisation du moteur Unreal chez AVSimulation